Une nouvelle preuve de l’inexorable réchauffement de la Terre nous a été donnée. Les Français, bien préparés par la canicule du mois de juillet, tant par la chaleur ressentie que par ce qu’en ont dit les médias, ont appris avec le reste de l’humanité qu’ils avaient alors assisté, sans le savoir sur le moment, à un événement d’ampleur mondiale et historique : un nouveau record de température, moyenne mensuelle cette fois-ci. N’y aurait-il aucune raison de tempérer ces déclarations alarmistes, puisque « c’est marqué su’l’journal » ? Les plumitifs laborieux au savoir modeste et à la critique en berne, plus connus sous le nom de journalistes, ayant été quelque peu à la peine, sans doute n’est-il pas inutile de revenir de manière sérieuse sur le sujet.

Avant de regarder d’un œil critique comment la presse a relaté l’événement, attardons-nous en premier lieu sur les données scientifiques. Mieux vaut d’abord savoir de quoi l’on s’occupe avant d’en parler. Car à procéder comme les journalistes, on ne peut livrer qu’une information dont tout esprit bien formé ne peut savoir que faire. Ce qu’en toute rigueur on ne peut nommer « information ». À reprendre des interprétations toutes faites, on prend le risque de servir les intérêts de ceux qui les livrent.

Comment donc élabore-t-on une température moyenne globale ? Pour cela, il faut bien sûr des données issues des stations de mesure, réparties à la surface de la Terre. Vu de l’extérieur, rien de plus aisé : il suffit de recueillir les données et d’en faire une moyenne. Ce n’est hélas pas si simple.

Il faut d’abord que le réseau météorologique soit de qualité, que la mesure de la température de l’air ne soit pas entachée de biais variables dans l’espace et dans le temps, ce qui aurait pour effet de fausser grandement l’analyse. Hélas, nombre de stations sont dans un environnement ayant connu une importante évolution, ce qui n’est pas sans conséquence dans la mesure. Une part importante d’entre elles est contaminée par ce que l’on appelle l’îlot de chaleur urbain, ou plus globalement le changement d’usage des sols, jusque dans les campagnes [1]. Même l’entretien de la station peut laisser à désirer, y compris au sein des pays les plus développés. Qu’en est-il des pays les moins favorisés ?

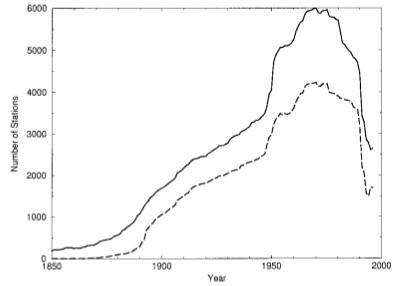

Il est par ailleurs bien évident que le nombre de stations utilisables n’a pas été stable. En très faible nombre à la fin du XIXe siècle, on en comptait près de 6 000 dans les années 1970. Par la suite, ce fut la dégringolade, avec notamment la fin de l’empire soviétique au début des années 1990. Actuellement, environ 2000 stations sont utilisées. Une très grande partie est située aux États-Unis, qui sont certes un vaste pays, mais malgré tout une infime partie du monde. Il faut donc faire avec un réseau de stations au nombre très variable dans le temps et dans l’espace.

- Évolution du nombre de stations météorologiques du réseau américain GHCN, utilisé par la NOAA et la NASA. Trait plein : ensemble des stations ; tiretés : stations comportant des enregistrements sur les minima et maxima

- Localisation de l’ensemble des stations du réseau GHCN en 1996 (a) et en 1900 (b)

Pour faire face à ces difficultés, des parades sont mises en œuvre. Pour pallier la qualité variable des données de température (changement d’instruments, déplacement de la station, évolution de l’environnement, etc.), on procède à des homogénéisations. Qui peuvent bien sûr se justifier. Mais sont toujours dans le sens de l’accentuation du réchauffement (augmentation des températures récentes, diminution des températures passées). Quant aux nombreuses régions du monde sans station, le Goddard Institute for Space Studies (GISS), qui dépend de la NASA et est l’un des principaux laboratoires travaillant à l’élaboration et au suivi de cette température moyenne globale, a la solution : il suffit d’interpoler avec les stations présentes à « proximité », jusqu’à 1 200 km ! C’est ainsi que l’on sait que la Bolivie a connu un important réchauffement, alors que le nombre de stations utilisées sur son sol est tombé après 1990 à.... zéro ! Comme si, ignorant tout de l’évolution de la température à Dijon, vous remplissiez ce vide grâce aux données de Madrid et Copenhague ! Cela ne paraît pas très sérieux et pour tout dire pas très scientifique ? Ce n’est pas ce que pensent le GIEC, les politiques, les médias...

Avec ces données mal réparties dans l’espace, il faut maintenant faire une moyenne. Chacun a sa recette propre. Le GISS divise la Terre en trois parties : la zone intertropicale et ce qui reste des hémisphères nord et sud. La moyenne de température est calculée pour chacune des parties, puis la moyenne globale est faite, avec une légère pondération (0,4 pour la zone intertropicale, la plus étendue, 0,3 pour chacune des deux autres). La Climate Research Unit (CRU), qui dépend de l’université d’East Anglia au Royaume-Uni, l’autre grand fournisseur de données sur le réchauffement global, notamment pour le GIEC, procède plus simplement : compte tenu de la disproportion du nombre de stations dans les deux hémisphères, le calcul est d’abord effectué pour chacun, puis la moyenne calculée en pondérant de manière à accorder une plus grande importance à l’hémisphère boréal (0,68 ; 0,32 pour l’hémisphère austral).

Avec un tel bricolage, en utilisant les outils de la science et en croyant probablement en faire, on obtient une température moyenne des continents. Lesquels – faut-il le rappeler ? – représentent moins de 30 % de la surface de la Terre. Si l’on veut obtenir une température moyenne dite globale, il faut des données concernant les vastes espaces occupés par les océans. C’est là que cela devient vraiment risible.

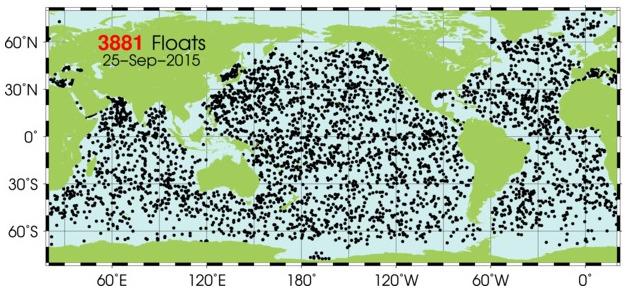

Puisque les données utilisées pour les continents sont des températures de l’air mesurées à environ 1,5 ou 2 mètres au-dessus du sol, il faudrait en toute logique et en toute rigueur faire de même au-dessus de la surface des océans. Or, de telles mesures n’existent pas. Qu’à cela ne tienne, on utilise alors la température de surface des océans. Que l’on connaît grâce à un réseau de bouées dérivantes, en nombre important (3881), mais forcément un peu dérisoire face à l’ampleur de la tâche (361 millions de km²), et par les mesures effectuées par les bateaux.

- Emplacement, au 25 septembre 2015, des bouées dérivantes ARGO, mesurant, entre autres, les températures de surface des océans

La CRU (en association avec le Hadley Centre britannique, qui apporte les données marines) utilise des données de températures moyennes mensuelles sur une grille dont la maille fait un degré de latitude sur un degré de longitude (en simplifiant, un carré de 500 km de côté). Même si les océans ont, y compris en surface, une inertie thermique beaucoup plus importante que les continents, autrement dit que leur température est beaucoup moins sujette à fluctuation et que l’ont peut se satisfaire de moins de données que les deux quotidiennes sur les continents, il est assez surprenant de se dire que chaque maille de cette vaste grille est pourvu d’un nombre suffisant de mesures thermiques pour obtenir une moyenne mensuelle qui tienne la route. Nul doute qu’en maintes régions du monde, loin des voies maritimes et pour peu qu’aucune bouée n’y soit présente, la moyenne doit se résumer parfois à une seule valeur. Le calcul est alors vite fait ! Quoi qu’il en soit, le Hadley Centre affirme ne procéder à aucune interpolation et, de fait, il y a toujours des coins de l’océan mondial restant « blancs », sans données.

Afin de suivre une évolution de long terme, il faut bien sûr pouvoir remonter dans le temps, aussi loin que possible. Pour l’esprit scientifique, prêt à concéder que l’information sur la température moyenne mensuelle de l’océan mondial pour l’époque actuelle est à manipuler avec prudence, en sachant qu’il y a une imprécision encore assez importante (mais sans doute moins que pour les continents), il faut se résoudre à accepter que, pour le passé, la tâche est impossible, qu’il nous reste très largement inaccessible. Pas pour le Hadley Centre, dont la base de données remonte à 1850. Sans bouées dérivantes capables de nombreuses mesures, mais avec tout de même quelques navires remontant de temps à autre un saut d’eau afin d’en mesurer la température. Et plus tard, sur les bateaux plus modernes, les techniques de mesure évoluant dans le temps, avec des biais eux aussi changeants. Mais qu’on ne s’alarme pas. Pas plus qu’ailleurs, les données utilisées ne sont brutes. Il y a là encore de nombreuses corrections, elles aussi réactualisées de temps à autre. La marge d’erreur serait-elle malgré tout bien supérieure au phénomène que l’on souhaite étudier ? Apparemment pas. Sinon, on ne pourrait rien conclure et le but est quand même la conclusion...

Avec maintenant ces données concernant d’une part les continents et, d’autre part, les océans, il n’y a plus qu’à faire la moyenne de ces moyennes, en pondérant en fonction du pourcentage de chacun d’eux à la surface de la Terre. Nous voilà désormais avec une variable dont on peut suivre l’évolution dans le temps, autrement dit mesurer le réchauffement climatique (qu’il soit anthropique ou non importe peu en l’occurrence), estimé à quelques dixièmes de degré Celsius sur un siècle : 0,74 °C entre 1906 et 2005. On appréciera la précision à deux décimales près, sachant le bricolage nécessaire pour y parvenir.

Or, donc, une nouvelle fracassante, de portée mondiale. Un marronnier médiatique pouvant surgir à tout moment, une véritable antienne : il a fait chaud, très chaud, vraiment très, très chaud.

Puisqu’il n’est pas encore interdit d’être taquin et que l’on a le droit de citer, ne boudons pas notre plaisir et revenons brièvement sur quelques écrits trouvés dans la presse mainstream.

Le Figaro titre audacieusement que « Le mois de juillet 2015 a été le plus chaud de l’histoire », avant de nous apprendre que celle-ci ne commence pas avec l’écriture, comme on nous l’a expliqué à l’école, mais avec les premières données météorologiques en 1800. Et d’enfoncer le clou sous le poids du nombre :

« La Nasa, l’Agence américaine Océanique et atmosphérique et l’Agence météorologique japonaise ont en effet toutes trois confirmé que ce mois de juillet 2015 a été le plus chaud pour l’ensemble de la planète depuis le début des données météorologiques en 1800. »

On ne sait pas où le journaliste est allé chercher cette date. La NASA et la NOAA font débuter leur données en 1880, tandis que l’agence japonaise se contente de 1891.

Puis de poursuivre en expliquant que, d’après la Nasa (plus précisément le GISS, anciennement dirigé par l’inénarrable James Hansen [2]), « la température moyenne au sol (sans doute le journaliste tente-t-il de parler de la température de surface) et sur [sic !] les océans a été de 0,75 °C au-dessus de la moyenne du XXe siècle ». Encore une fois, le gratte-papier chargé de rédiger cet article n’a pas été fichu d’obtenir une information précise. Le GISS a choisi comme période de référence la période 1951-1980, et non l’ensemble du siècle dernier.

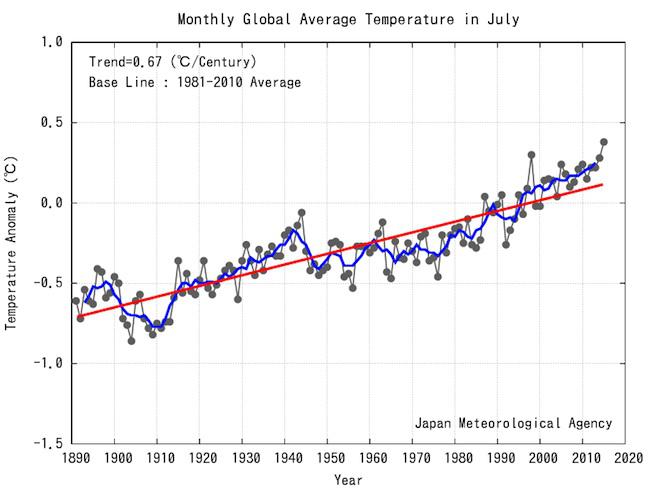

Le suite ne vaut guère mieux, puisque cette fois-ci, non seulement le journaliste écrit une ânerie, mais, qui plus est, en se contredisant. Après nous avoir dit que les scientifiques japonais parvenaient aux mêmes conclusions que les Américains, il affirme maintenant que « l’Agence météorologique japonaise a publié un graphique qui démontre que le mois de juillet est le deuxième mois le plus chaud après le mois de juillet 1998 ». Il suffit de se reporter à cette courbe de température de l’agence nippone, mise en lien hypertexte sur le site du Figaro, pour se rendre compte que c’est bien 2015 qui arrive en tête, devant 1998, comme dit plus haut dans l’article.

- Anomalies de température moyenne mensuelle au mois de juillet depuis 1891 d’après l’Agence météorologique japonaise

Écarts à la moyenne calculés sur la période 1981-2010 (en noir). Ligne bleue : lissage par moyenne mobile calculée sur 5 ans ; ligne rouge : tendance de long terme (régression linéaire)

Atlantico, qui annonce d’emblée le sérieux de ses références (« Nicolas Hulot avait probablement raison dans son documentaire Le Syndrome du Titanic (2008) lorsqu’il nous mettait en garde contre le réchauffement climatique »), s’est visiblement très fortement inspiré de l’article du Figaro paru la veille, puisqu’il reprend les informations précédentes avec précisément les mêmes erreurs. Des fois que l’on ne sache pas que la première source d’information des journalistes sont les journalistes eux-mêmes...

Malgré la faible marge de manœuvre pour trouver un titre original, les journalistes tentent malgré tout de se distinguer, avec une maladresse certaine :

![]() Atlantico : « Juillet 2015 : le plus chaud mois de juillet dans le monde depuis 1800 ». Outre l’erreur déjà mentionnée, précisons qu’il eût été étonnant, pour le moins, que juillet fût le mois de janvier le plus chaud...

Atlantico : « Juillet 2015 : le plus chaud mois de juillet dans le monde depuis 1800 ». Outre l’erreur déjà mentionnée, précisons qu’il eût été étonnant, pour le moins, que juillet fût le mois de janvier le plus chaud...

![]() La Croix : « La planète a battu son record de chaleur cet été ». Quand on ne précise pas plus, on fait généralement référence au record absolu, qui lui ne concerne qu’une seule station et tient toujours, depuis plus d’un siècle [3]. Il s’agit ici de la température globale moyenne mensuelle, dont le record aurait été battu selon les reconstructions expliquées ci-dessus. C’est évidemment beaucoup moins sûr que pour une station isolée, surtout si elle est restée rurale, dans un environnement n’ayant pas trop évolué du point de vue paysager.

La Croix : « La planète a battu son record de chaleur cet été ». Quand on ne précise pas plus, on fait généralement référence au record absolu, qui lui ne concerne qu’une seule station et tient toujours, depuis plus d’un siècle [3]. Il s’agit ici de la température globale moyenne mensuelle, dont le record aurait été battu selon les reconstructions expliquées ci-dessus. C’est évidemment beaucoup moins sûr que pour une station isolée, surtout si elle est restée rurale, dans un environnement n’ayant pas trop évolué du point de vue paysager.

![]() Le Nouvel Obs : « Juillet 2015, le mois le plus chaud jamais enregistré », ou le sensationnalisme par enfonçage de portes ouvertes, puisque juillet est le mois le plus chaud de l’année à l’échelle globale.

Le Nouvel Obs : « Juillet 2015, le mois le plus chaud jamais enregistré », ou le sensationnalisme par enfonçage de portes ouvertes, puisque juillet est le mois le plus chaud de l’année à l’échelle globale.

![]() Le Parisien tente la surenchère : « Le début de l’année 2015 a été le plus chaud depuis... 1880 ! » Avec l’évolution climatique, c’est toujours worse than we thought [4]...

Le Parisien tente la surenchère : « Le début de l’année 2015 a été le plus chaud depuis... 1880 ! » Avec l’évolution climatique, c’est toujours worse than we thought [4]...

![]() Slate.fr : « Juillet 2015, le mois le plus chaud de l’année qui devrait être la plus chaude jamais enregistrée ». Quand on connaît déjà la nouvelle, on comprend où le journaliste veut en venir, mais, en fait, il se contente de nous informer que juillet est cette année le mois le plus chaud, ce qui est toujours le cas. Quant à savoir si l’année 2015 sera la plus chaude depuis le milieu ou la fin du XIXe siècle, attendons, même s’il y a tout lieu de le penser : il n’y a pas seulement instrumentalisation de la science par la politique, mais pilotage politique de la science, qui n’en est donc finalement plus.

Slate.fr : « Juillet 2015, le mois le plus chaud de l’année qui devrait être la plus chaude jamais enregistrée ». Quand on connaît déjà la nouvelle, on comprend où le journaliste veut en venir, mais, en fait, il se contente de nous informer que juillet est cette année le mois le plus chaud, ce qui est toujours le cas. Quant à savoir si l’année 2015 sera la plus chaude depuis le milieu ou la fin du XIXe siècle, attendons, même s’il y a tout lieu de le penser : il n’y a pas seulement instrumentalisation de la science par la politique, mais pilotage politique de la science, qui n’en est donc finalement plus.

Revenons un instant sur la présentation des différentes températures moyennes obtenues par les différents organismes de recherche. Que ce soit pour des données mensuelles ou annuelles, ce sont rarement les résultats bruts qui sont utilisés, mais les écarts à une moyenne calculée sur une période choisie, variable là encore d’un organisme de recherche à un autre. Ces écarts à la moyenne sont appelés en statistiques des « anomalies ». C’est particulièrement utile pour la cartographie, afin de mettre en évidence les endroits qui ont été nettement plus chauds ou plus froids qu’en moyenne. Ces anomalies, ici positives, seront d’autant plus grandes que la période de référence sur laquelle est calculée la moyenne, autrement appelée « normale », est relativement fraîche. On ne s’étonnera donc pas que des trois organismes déjà cités, désignant tous 2015 comme ayant eu le mois de juillet le plus chaud, les médias ont retenu les deux mettant en avant les plus importants écarts à la moyenne : la NASA (le GISS), avec 0,75 °C de plus que la moyenne de la période 1951-1980, et surtout la NOAA, avec une anomalie de 0,80 °C par rapport à l’ensemble des mois de juillet du XXe siècle. Notons que l’anomalie rapportée par la presse était de 0,85 °C, mais qu’elle a été corrigée par la NOAA à 0,81 °C au début de la rédaction de cet article, avant d’être à nouveau réévaluée à la baisse, d’un centième de degré Celsius.

Il ne s’agit pas là de grande subtilités, mais elles ont pourtant eu pour effet d’embrouiller quelque peu l’esprit des journalistes. La Croix écrit en effet :

« L’année 2014 avait été déjà rapportée comme la plus chaude sur Terre : sur l’année complète, la température moyenne au sol et sur les océans avait été supérieure à celle du XXe siècle : 0,69 °C de plus. Les précédents records de 2005 et 2010 de 0,04 degré ont donc été largement dépassés. »

La confusion est totale ! L’anomalie de température de 0,69 °C concerne le mois de juillet 2014 et non l’ensemble de cette année, qui atteint pour la NOAA 0,74 °C. Par ailleurs les anomalies respectives de la température globale annuelle pour 2005 et 2010 sont de 0,66 °C et 0,70 °C, soit des différences à chaque fois de 0,04 °C. Le journaliste confond donc une anomalie mensuelle avec une anomalie annuelle, puis des anomalies annuelles avec les différences entre ces anomalies. Il y a encore des progrès à faire, mais que La Croix se console, Slate.fr (citant à n’en pas douter Slate.com), qui tente de relayer le prestigieux Washington Post, est lui aussi dans la confusion, à moins qu’il ne la cultive dans l’esprit de ses lecteurs : d’après l’Agence météorologique japonaise, « cinq des sept derniers mois jusque-là ont été les chauds [sic !] enregistrés. Les deux autres (février et mars) ont pris la troisième position ». C’est vraiment à se demander s’il y a un problème de compréhension ou de grandes difficultés à s’exprimer, car si l’on s’en tient strictement à ce qui est dit, il faudrait comprendre que le mois de février 2015, par exemple, a été plus chaud que juillet 2014. Ce n’est bien évidemment pas le cas. Ce qui est comparé, c’est bien sûr différentes années pour un mois donné. Le journaliste s’est risqué à comparer des anomalies de température (et qui plus est, les résultats ne sont pas exactement ceux annoncés par le Post [5]) comme on compare des températures entre elles. Cela reviendrait à dire qu’il a fait plus chaud au centre du Groenland, qui aurait connu une température 2 °C au dessus de sa moyenne, qu’en plein centre du Sahara, 2 °C moins chaud que la « normale »...

Les différences de températures entre nouveau record et record précédent sont donc, on le voit, infimes. Ridicules même, pourrait-on dire : eu égard à la manière dont sont obtenues les moyennes, en quoi de tels écarts peuvent-ils être jugés pertinents ? Pour la NOAA, la différence avec les deux précédents mois de juillet les plus chauds (à égalité) est de 0,07 °C. Quant au GISS, juillet 2015 dépasse juillet 2011 de 0,01 °C, qui lui-même dépassait juillet 2009 de 0,02 °C, lui-même 0,01 °C au-dessus de juillet 1998. C’est ainsi que le réchauffement continue médiatiquement, les records se succédant par bonds dont la mesure est de l’ordre du centième de degré Celsius et que ces records tiennent tous dans les dix ou quinze dernières années. Ce qu’en bon esprit critique il convient d’appeler un plateau, l’évolution des températures étant quasi nulle.

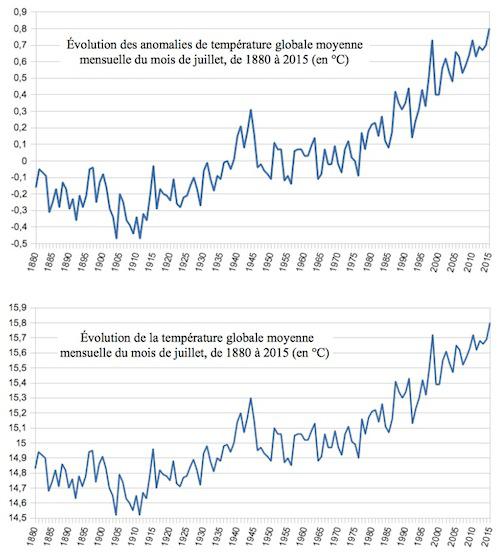

On le voit, tout est dans la présentation qui est faite des données. Jusque dans leur représentation graphique. L’allure d’une courbe de température est la même que celle des anomalies de températures correspondantes, pour peu que l’on ajuste comme il faut l’échelle des ordonnées :

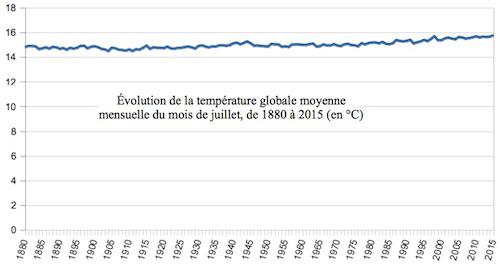

On pourrait donc aisément se contenter de présenter les simples températures moyennes mensuelles et non leurs anomalies. Mais ces dernières présentent un avantage certain : sans artifice au niveau de l’échelle, les valeurs se répartissent autour de zéro, qui représente la moyenne de la période de référence. Rien de tel avec les températures. Pour que les deux courbes aient la même allure sur les graphiques ci-dessus, il faut ici que l’échelle des ordonnées du second commence à 14,5 °C, ce qui pourrait être dénoncé comme une astuce un peu grossière. Si, au contraire, on la fait débuter à zéro, la représentation des mêmes données produit un tout autre effet :

Ce dernier graphique est beaucoup plus conforme à la tendance qu’il montre, puisque, selon les données de la NOAA, l’augmentation de la température moyenne globale du mois de juillet depuis 1880 est de 0,65 °C par siècle. On en conviendra, il n’y a là guère de quoi affoler, ce pour quoi une bonne courbe montant en flèche fait au contraire totalement l’affaire. Raison pour laquelle c’est bien sûr une telle illustration qui est mise sous le nez du lecteur, qui pourrait ne pas être affolé par des valeurs de températures somme toute guère alarmantes quand l’expert médiatique n’est pas présent pour rappeler que 0,65 °C en un siècle, c’est considérable et sans précédent, ce qui est faux, et qu’en conséquence, il faut agir.

Car c’est là que veulent en venir les prophètes de l’apocalypse climatique : la politique, l’action devant découler nécessairement du discours alarmiste. Slate.fr n’hésite pas à donner la parole à un blogueur américain mainstream, avant de s’aventurer sur la politique états-unienne et les prochaines élections présidentielles :

« Pour lui, "le réchauffement climatique est réel. Il est causé par des humains. Et il est dangereux. Très dangereux". Même conclusion chez Slate.com, qui, de son côté, passe en revue les points de vue des candidats Républicains sur le sujet. Et devinez quoi ? Ils ne sont pas tout à fait d’accord avec cette affirmation. »

Et devinez quoi ? Slate.com appartient au même groupe que le Washington Post, favorable aux Démocrates...

De leur côté, les journaux français se focalisent sur la conférence sur le climat (COP21) qui se tiendra à Paris en fin d’année. Selon Le Figaro, représentatif de l’unanimité en la matière, la COP21 « devrait ainsi avoir de nouveaux arguments pour inciter les chefs d’État à prendre des mesures collectives ». Des fois que l’on n’ait pas compris le pourquoi de tout ce foin médiatico-scientifique...

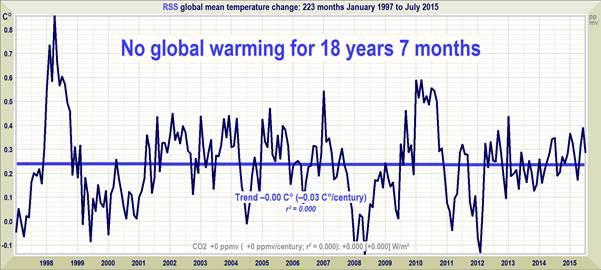

Mais pour résister à la vague unanimiste, il y a un autre moyen que le décorticage des données sujettes à caution, utilisées par tous ceux qui ont une idée, mondialiste, derrière la tête. Un moyen rapide, net et sans bavure : les satellites. Certes, les données ne parlent pas exactement de la même chose. Le réseau de stations au sol et de bouées en mer permet d’obtenir une température dite de surface, alors que les satellites fournissent des indications sur la température de la basse atmosphère. Dans un contexte de soi-disant réchauffement global pour cause d’émissions de gaz à effet de serre, c’est justement un atout de premier ordre : outre une couverture spatiale exceptionnelle, ils ont pour eux d’éviter l’écueil des changements d’usage des sols et notamment les îlots de chaleur urbains. Leur défaut est d’avoir une profondeur historique forcément réduite, mais de 35 ans tout de même. Une durée amplement suffisante pour suivre le dernier épisode de l’évolution récente du climat, celle marquée, nous dit-on, de l’empreinte de l’Homme.

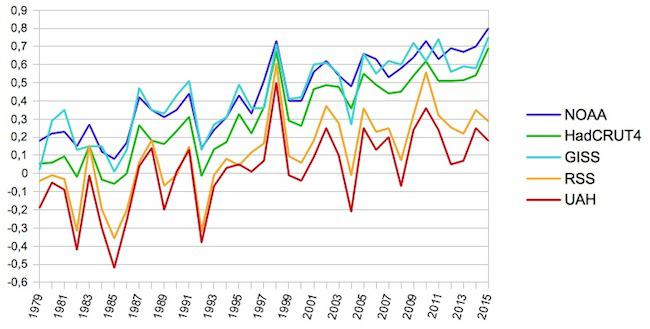

Si l’Agence spatiale américaine préfère confier l’analyse de la température globale moyenne à des scientifiques (du GISS) tournant résolument le dos aux données satellitaires, celles-ci sont en revanche exploitées par deux sources communément citées : la société privée Remote Sensing System (RSS) et l’université d’Alabama à Huntsville (UAH). Pour l’une et l’autre, juillet 2015 n’est pas vraiment un record, puisqu’il n’arrive qu’en huitième et neuvième position parmi les 37 mois de juillet depuis 1979 inclus. On comprend que les journalistes ne se soient pas empressés d’y aller regarder de plus près, des fois que la vérité nuise à la bonne cause.

- Anomalies de température du mois de juillet depuis 1979, d’après les données recueillies au sol (NOAA, GISS, HadCRUT4) et par les satellites (RSS et UAH)

Que juillet 2015 apparaisse en tête de longues séries incertaines recueillies au sol, mais soit relégué presque à la dixième place par les satellites, aux données beaucoup plus sûres, devrait interroger la presse d’information. Mais l’exactitude n’est sans doute pas le moyen idéal pour servir son but réel, qui n’est guère d’informer, mais d’orienter. Raison pour laquelle il faut certainement se réjouir de ne pas être « dans les petits papiers du Mercure François » !

Pour rappel, la mise à jour de la marche irrésistible du réchauffement climatique :

- « Pas de réchauffement global depuis 18 ans et 7 mois » (anomalies de températures moyennes mensuelles, données RSS)

et

et  !

!