Deux enquêtes récentes ont révélé l’ampleur de l’usage de l’intelligence artificielle (IA) dans la guerre génocidaire menée à Gaza, mais aussi dans le contrôle de la population des territoires palestiniens occupés. Les start-up, souvent présentées comme un symbole de la modernité d’Israël, sont en réalité une partie intégrante du complexe militaire de ce pays. Une troisième enquête montre comment le géant américain Microsoft est partie prenante de cette stratégie de mort visant les Palestiniens.

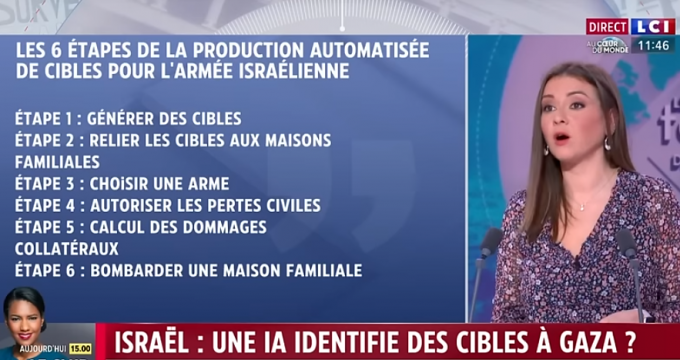

« Une fois que l’on passe à l’automatisation, la génération des cibles échappe à tout contrôle. » Cette phrase qui révèle un emballement meurtrier des méthodes de l’armée israélienne a été prononcée par l’un de ses officiers ayant participé à l’opération « Glaive de fer » à Gaza, qui a suivi l’attaque du 7 octobre 2023. Elle illustre le rôle grandissant de l’Intelligence artificielle (IA) dans la stratégie génocidaire de Tel-Aviv.

Lors de ses interventions militaires, Israël a déjà eu recours à l’IA pour élaborer des processus d’identification des cibles. Mais, pour la première fois après le 7 octobre 2023, l’armée lui a délégué la responsabilité de leurs assassinats et l’autorisation d’élargir le cercle des victimes collatérales, comme l’a révélé une enquête du journaliste Yuval Abraham de +972 magazine, fondée en partie sur des documents obtenus par Drop Site News et menée auprès de sources militaires souhaitant garder l’anonymat.

Trente-sept mille cibles potentielles

Selon Yuval Abraham, l’usage de l’IA qui antérieurement n’était qu’un auxiliaire de fichage et de prise de décision s’est intensifié alors que la part de l’intervention humaine s’est restreinte. En 2021, l’actuel commandant de l’unité d’élite du renseignement israélien 8200, dans un manuel militaire au titre éloquent, « L’équipe humain-machine ou comment créer une synergie entre humain et intelligence artificielle qui va révolutionner le monde », évoquait la nécessité d’un programme de recueil des données et d’automatisation des décisions grâce à l’IA. Un tel projet est devenu opérationnel en 2024 sous le nom de « Lavender » (Lavande).

Dès que Lavender désigne un individu comme étant un militant du Hamas, ce repérage fait office d’ordre d’exécution, sans que soient vérifiées les données qui ont conduit la machine à cette conclusion. En faisant abstraction de leur rang ou de leur grade, l’IA a sélectionné 37 000 Palestiniens selon le principe des « traits » communs aux membres du Hamas et du Djihad islamique, l’armée assumant le risque que cette similarité l’induise en erreur et que le programme désigne des policiers, des membres de la défense civile, des parents de militants, des homonymes comme cibles potentielles. C’est exactement ce qui est arrivé.

Précédemment, l’assassinat d’une seule personne était conditionné par un processus d’identification qui permettait de s’assurer que celle-ci était bien un officier de haut rang de la branche militaire du Hamas, les seuls susceptibles d’être bombardés à leur domicile. Lorsque ce processus a été délégué à l’IA, la phase de vérification de l’identité du suspect a été réduite à une poignée de secondes avant que ne soit déclenché un tir d’élimination.

Lavender a donc joué un rôle déterminant dans l’usage intensif des bombardements, en particulier pendant les premières phases de la guerre durant lesquelles les officiers, couverts par leur hiérarchie, n’ont pas été tenus de vérifier les critères de choix de la machine (bien qu’elle se trompe dans 10 % des cas), s’assurant seulement que la cible était un homme puisque le Hamas et le Djihad islamique n’ont pas recours à des combattantes.

Un fonctionnement qui a conduit l’armée israélienne à tuer quelques 15 000 Palestiniens au cours des six premières semaines de son intervention à Gaza. Ce carnage s’est interrompu non pas pour des raisons morales, mais par peur de manquer de bombes. Une crainte infondée puisque l’aide américaine s’est poursuivie sans interruption.

Deux pour cent de la population de Gaza éliminée en dix mois

B., l’une des sources anonymes de Yuval Abraham, a admis que « en temps de guerre, on n’a pas le temps d’identifier chaque cible. On est donc prêt à accepter la marge d’erreur de l’utilisation de l’intelligence artificielle, à risquer des dommages collatéraux et la mort de civils, à attaquer par erreur, et à s’en accommoder. » Il explique que « la raison de cette automatisation était la volonté constante de créer davantage de cibles à assassiner. Le jour où il n’y avait pas de cibles (dont l’évaluation des caractéristiques était suffisante pour autoriser une frappe), nous attaquions à un seuil plus bas. On nous mettait constamment la pression : “Apportez-nous plus de cibles” Ils nous ont vraiment crié dessus. Nous avons fini (par tuer) nos cibles très rapidement ».

Cette injonction a eu pour effet que 2 % de la population gazaouie a été éliminée en 10 mois, selon les chiffres officiels. L’ambition meurtrière n’ayant pas de limite, l’extension du recensement automatique des hommes à abattre a été doublée par « The Gospel » (L’Évangile), un autre système d’IA, permettant de les localiser au moment où ils pénétraient dans leurs lieux d’habitation. Un couplage d’informations, baptisé de façon cynique « Where’s Daddy » (Où est papa ?), qui a permis de frapper les victimes, à l’aube, chez elles, lors de bombardements n’épargnant pas leurs familles.

Selon les chiffres de l’Organisation des Nations unies (ONU), dans le premier mois de la guerre, plus de la moitié des victimes — 6 120 personnes — appartenaient à l’une des 1 340 familles tuées à l’intérieur de leur maison. Dans ce contexte d’anéantissement, il n’est pas surprenant que la plupart soient des femmes et des enfants.

D’autant que l’armée israélienne a privilégié l’usage de bombes non guidées à la précision incertaine, dites « bombes muettes » car elles sont difficiles à détecter. Une autre source anonyme de Yuval Abraham en a décrit le protocole d’utilisation :

« La seule question était de savoir s’il était possible d’attaquer le bâtiment en limitant les dommages collatéraux. En effet, nous menions généralement les attaques avec des bombes muettes, ce qui signifiait détruire littéralement toute la maison et ses occupants. Mais même si une attaque est évitée, on s’en fiche, on passe immédiatement à la cible suivante. Grâce au système, les cibles ne sont jamais épuisées. Il y en a encore 36 000 qui attendent. »

Cette question des dommages collatéraux a été traitée de façon différente selon les phases de l’intervention israélienne. Au cours de la semaine qui a suivi le 7 octobre 2023, Israël a fait fi des dommages collatéraux comme le confirme B. à Yuval Abraham :

« En pratique, on ne comptait pas vraiment les gens [dans chaque maison bombardée] parce qu’on ne pouvait pas vraiment savoir s’ils étaient chez eux ou non. Au bout d’une semaine, les restrictions sur les dommages collatéraux ont commencé. Le nombre est passé de quinze à cinq, ce qui a rendu nos attaques très difficiles, car, si toute la famille était à la maison, nous ne pouvions pas la bombarder. Puis ils ont à nouveau augmenté ce seuil. »

Ce qui a autorisé l’armée, en novembre 2023, lorsqu’il s’est agi d’assassiner Ayman Nofal, le commandant de la brigade centrale de Gaza du Hamas, à procéder au meurtre de 300 civils et à détruire par des frappes aériennes plusieurs bâtiments du camp de réfugiés d’Al-Bureij.

Un taux de létalité inconnu au XXIe siècle

Le 5 avril 2024, sollicitée par Radio Canada sur la crédibilité du reportage des deux médias israéliens, Brianna Rosen, qui travaille depuis 15 ans sur la militarisation des nouvelles technologies, dont l’IA, estime que la réponse israélienne accrédite des informations fondamentales mises de l’avant par l’enquête journalistique. « Il y a beaucoup de choses que nous ignorons sur l’utilisation de l’IA par Israël à Gaza. Israël n’a pas été transparent à propos de ces systèmes classifiés », fait-elle valoir, dans un courriel à Radio-Canada. « Mais même si nous ne pouvons pas vérifier tous les détails dans l’article du magazine +972, nous pouvons vérifier certains aspects sur la base des propres déclarations d’Israël », souligne la chercheuse à l’Université d’Oxford et à Just Security, un forum en ligne qui analyse la législation et la politique entourant la sécurité nationale des États-Unis.

« Voici ce que nous savons avec certitude : Israël utilise des systèmes basés sur l’IA pour accélérer le rythme et l’ampleur de la guerre. » Une constatation validée par sa consœur Amélie Ferey, chercheuse au Laboratoire de recherche sur la défense (LRD) à l’Institut français des relations internationales (IFRI) dans un entretien du 18 juillet 2024 à Mediapart : « Ce que l’on voit à Gaza, c’est un taux de létalité quasiment inconnu au XXIe siècle. »

[…]

Microsoft, une entreprise totalement engagée aux côtés de Tel-Aviv

Depuis le 7 octobre, l’armée israélienne a intensifié sa collaboration avec les services du cloud et d’IA de Microsoft et de son partenaire OpenAI, dont le personnel a pris place dans différentes unités pour soutenir le déploiement de ses technologies. Le site Web de l’entreprise reconnaît que « les experts Microsoft de-viennent partie intégrante de l’équipe (du client). »

[…]

Avant 2024, les conditions d’OpenAI, partenaire de Microsoft, comprenaient une clause interdisant l’utilisation de ses services pour des activités « militaires et de guerre ». Mais en janvier 2024, alors que l’armée israélienne a augmenté sa dépendance à GPT-4 tout en bombardant la bande de Gaza, l’entreprise a discrètement supprimé cette clause de son site Web et a élargi ses partenariats avec les armées et les agences de renseignement nationales — ce dont, bien sûr, a profité Israël.

Lire l’article entier sur orientxxi.info

Même LCI en a parlé en 2024

et

et  !

!